고정 헤더 영역

상세 컨텐츠

본문

왜 2026년 기업들은 소버린 AI에 열광하는가?

과거에는 범용적인 거대언어모델(LLM)을 API 형태로 사용하는 것이 대세였다면, 2026년 현재는 상황이 완전히 달라졌어요. 기업들은 이제 자신의 소중한 내부 데이터가 외부 서버로 유출될 가능성을 극도로 경계하고 있죠. 여기서 등장한 개념이 바로 '소버린 AI'예요. 이는 국가나 기업이 스스로의 데이터와 인프라에 대해 완전한 통제권을 갖는 AI 체계를 의미합니다.

특히 금융, 의료, 제조 분야처럼 보안이 생명인 산업군에서는 퍼블릭 AI 모델을 그대로 쓰기엔 리스크가 너무 컸어요. 그래서 대두된 것이 소형언어모델(sLLM)입니다. sLLM은 파라미터 수는 적지만 특정 도메인에 특화되어 있어, 기업 내부 서버(On-premise)나 프라이빗 클라우드 환경에서도 충분히 효율적으로 돌아가거든요.

기업 전용 sLLM 구축을 위한 3단계 전략

성공적인 소버린 AI 인프라를 구축하기 위해서는 단순히 모델을 가져오는 것 이상으로 정교한 튜닝 전략이 필요해요. 제가 현장에서 느낀 가장 효율적인 3단계 프로세스를 공유해 드릴게요.

첫 번째는 데이터 정제 및 합성 데이터 활용이에요. sLLM은 데이터의 양보다 질이 중요합니다. 기업 내부에 흩어진 비정형 데이터를 AI가 학습하기 좋은 형태로 가공하고, 부족한 데이터는 고품질의 합성 데이터(Synthetic Data)로 보완해야 하죠.

두 번째는 PEFT(Parameter-Efficient Fine-Tuning) 기법 적용입니다. LoRA나 QLoRA 같은 기법을 사용하면 전체 파라미터를 건드리지 않고도 적은 연산 자원으로 모델을 최적화할 수 있어요. 이는 인프라 비용을 획기적으로 줄여주는 2026년의 표준 기술이 되었죠.

세 번째는 RAG(검색 증강 생성)와의 결합입니다. 모델이 학습하지 못한 최신 내부 정보를 실시간으로 참조할 수 있도록 벡터 데이터베이스를 연동하는 것이죠. 이렇게 하면 모델의 환각(Hallucination) 현상을 최소화하면서도 정확한 답변을 얻을 수 있습니다.

인프라 비용 효율화를 위한 비교 분석

구축 방식에 따른 비용과 보안 수준을 비교해 보았습니다. 우리 기업 상황에 맞는 모델이 무엇인지 판단해 보세요.

| 구분 | 퍼블릭 LLM API | 소버린 sLLM (On-prem) |

|---|---|---|

| 데이터 주권 | 낮음 (외부 전송) | 매우 높음 (자체 보유) |

| 구축 비용 | 낮음 (사용량 기반) | 초기 인프라 비용 발생 |

| 도메인 특화 | 범용적 | 매우 높음 (커스텀 튜닝) |

- ✅ 데이터 주권 확보: 2026년 기업 AI 경쟁력의 시작은 외부 유출 없는 인프라 구축입니다.

- ✅ sLLM의 효율성: 적은 파라미터로 특정 산업 도메인에서 거대 모델 이상의 성능을 발휘합니다.

- ✅ 고도화된 튜닝: LoRA, RAG 기술을 접목하여 할루시네이션을 방지하고 비용을 절감하세요.

- ✅ 지속 가능한 운영: 내부 인력의 업스킬링을 통해 모델의 사후 관리 체계를 마련해야 합니다.

❓ 자주 묻는 질문 (FAQ)

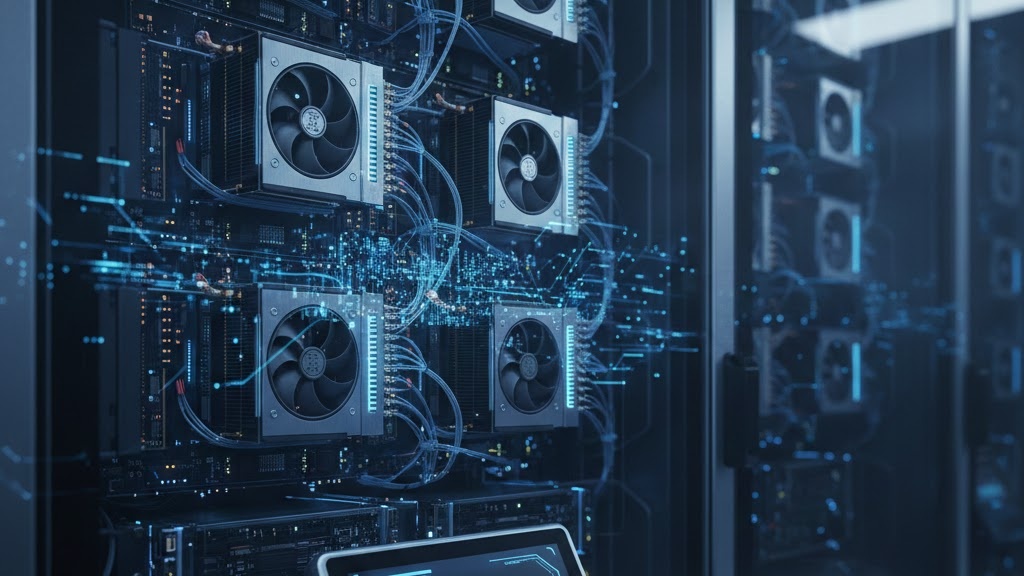

Q1: sLLM 구축 시 하드웨어 사양은 어느 정도여야 하나요?

A1: 2026년 기준, 효율적인 sLLM 운영을 위해서는 고성능 GPU(예: NVIDIA H100 등)가 권장되지만, 양자화(Quantization) 기술을 통해 보다 낮은 사양에서도 충분히 구동 가능합니다.

Q2: 데이터 보안이 왜 소버린 AI의 핵심인가요?

A2: 기업 비밀이나 개인 정보가 포함된 데이터를 외부 클라우드에 학습시킬 경우, 잠재적인 유출 및 권리 분쟁의 소지가 있기 때문입니다.